Come può la scienza trarre vantaggio dall'IA?

La pubblicazione mette in guardia dai malintesi nella gestione degli algoritmi predittivi

I ricercatori di chimica, biologia e medicina si rivolgono sempre più spesso a modelli di intelligenza artificiale per sviluppare nuove ipotesi. Tuttavia, spesso non è chiaro su quali basi gli algoritmi giungano alle loro conclusioni e fino a che punto possano essere generalizzati. Una pubblicazione dell'Università di Bonn mette ora in guardia dai malintesi nella gestione dell'intelligenza artificiale. Allo stesso tempo, evidenzia le condizioni in cui i ricercatori possono avere maggiore fiducia nei modelli. Lo studio è stato pubblicato sulla rivista Cell Reports Physical Science.

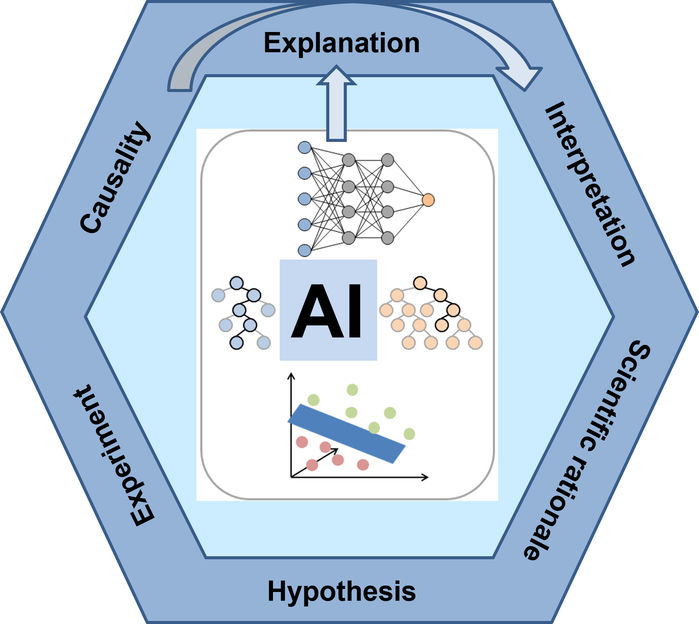

Modelli di intelligenza artificiale nelle scienze naturali: - Dalla spiegazione delle previsioni alla cattura delle relazioni causali.

Jürgen Bajorath/University of Bonn

Gli algoritmi di apprendimento automatico adattivo sono incredibilmente potenti. Tuttavia, hanno uno svantaggio: il modo in cui i modelli di apprendimento automatico arrivano alle loro previsioni spesso non è evidente dall'esterno.

Supponiamo di fornire all'intelligenza artificiale le foto di diverse migliaia di automobili. Se ora le si presenta una nuova immagine, di solito è in grado di identificare in modo affidabile se anche questa foto mostra un'automobile o meno. Ma perché? Ha davvero imparato che un'auto ha quattro ruote, un parabrezza e uno scarico? Oppure la sua decisione si basa su criteri in realtà irrilevanti, come l'antenna sul tetto? Se così fosse, potrebbe classificare anche una radio come un'automobile.

I modelli di intelligenza artificiale sono scatole nere

"I modelli di intelligenza artificiale sono scatole nere", sottolinea il Prof. Dr. Jürgen Bajorath. "Di conseguenza, non bisogna fidarsi ciecamente dei loro risultati e trarne conclusioni". L'esperto di chimica computazionale dirige il dipartimento AI in Life Sciences presso il Lamarr Institute for Machine Learning and Artificial Intelligence. È inoltre responsabile del programma di informatica delle scienze della vita presso il Bonn-Aachen International Center for Information Technology (b-it) dell'Università di Bonn. Nella pubblicazione attuale, ha analizzato la questione di quando è più probabile affidarsi agli algoritmi. E viceversa: quando no.

Il concetto di "spiegabilità" svolge un ruolo importante in questo contesto. Metaforicamente parlando, si riferisce agli sforzi compiuti dalla ricerca sull'IA per aprire uno spioncino nella scatola nera. L'algoritmo dovrebbe rivelare i criteri su cui si basa: le quattro ruote o l'antenna. "L'apertura della scatola nera è attualmente un tema centrale nella ricerca sull'IA", afferma Bajorath. "Alcuni modelli di IA vengono sviluppati esclusivamente per rendere più comprensibili i risultati di altri".

La spiegabilità, tuttavia, è solo un aspetto: la questione delle conclusioni che si possono trarre dai criteri decisionali scelti da un modello è altrettanto importante. Se l'algoritmo indica che ha basato la sua decisione sull'antenna, un essere umano sa immediatamente che questa caratteristica è poco adatta a identificare le automobili. Ciononostante, i modelli adattivi sono generalmente utilizzati per identificare correlazioni in grandi insiemi di dati che gli esseri umani potrebbero non notare. In questo caso siamo come degli alieni che non sanno che cosa rende un'automobile: Un alieno non sarebbe in grado di dire se un'antenna è un buon criterio o meno.

I modelli di linguaggio chimico suggeriscono nuovi composti

"C'è un'altra domanda che dobbiamo sempre porci quando usiamo procedure di IA nella scienza", sottolinea Bajorath, che è anche membro dell'Area di Ricerca Transdisciplinare (TRA) "Modellistica": "Quanto sono interpretabili i risultati?". I modelli di linguaggio chimico sono attualmente un tema caldo nella ricerca chimica e farmaceutica. È possibile, ad esempio, alimentarli con molte molecole che hanno una certa attività biologica. Sulla base di questi dati di input, il modello impara e suggerisce idealmente una nuova molecola che ha la stessa attività ma con una nuova struttura. Questo metodo viene anche definito modellazione generativa. Tuttavia, il modello di solito non è in grado di spiegare perché arriva a questa soluzione. Spesso è necessario applicare successivamente metodi di IA spiegabili.

Tuttavia, Bajorath mette in guardia dal rischio di sovrainterpretare queste spiegazioni, cioè di anticipare che le caratteristiche che l'IA considera importanti causano effettivamente l'attività desiderata. "Gli attuali modelli di IA non capiscono essenzialmente nulla di chimica", afferma. "Sono di natura puramente statistica e correlativa e prestano attenzione a qualsiasi caratteristica distintiva, indipendentemente dal fatto che queste caratteristiche siano o meno rilevanti dal punto di vista chimico o biologico". Ciononostante, potrebbero anche avere ragione nella loro valutazione: forse la molecola suggerita ha le capacità desiderate. Le ragioni di ciò, tuttavia, possono essere completamente diverse da quelle che ci aspetteremmo sulla base delle conoscenze chimiche o dell'intuizione. Per valutare la potenziale causalità tra le caratteristiche che guidano le previsioni e i risultati dei corrispondenti processi naturali, sono in genere necessari esperimenti: I ricercatori devono sintetizzare e testare la molecola, così come altre molecole con il motivo strutturale che l'IA ritiene importante.

I controlli di plausibilità sono importanti

Questi test richiedono molto tempo e sono costosi. Bajorath mette quindi in guardia da un'eccessiva interpretazione dei risultati dell'IA nella ricerca di relazioni causali scientificamente plausibili. A suo avviso, un controllo di plausibilità basato su una solida motivazione scientifica è di importanza cruciale: La caratteristica suggerita dall'IA spiegabile può essere effettivamente responsabile della proprietà chimica o biologica desiderata? Vale la pena seguire il suggerimento dell'IA? Oppure si tratta di un probabile artefatto, una correlazione individuata casualmente, come l'antenna dell'auto, che non è affatto rilevante per la funzione effettiva?

Lo scienziato sottolinea che l'uso di algoritmi adattivi ha fondamentalmente il potenziale per far progredire in modo sostanziale la ricerca in molte aree della scienza. Tuttavia, bisogna essere consapevoli dei punti di forza di questi approcci e soprattutto delle loro debolezze.

Nota: questo articolo è stato tradotto utilizzando un sistema informatico senza intervento umano. LUMITOS offre queste traduzioni automatiche per presentare una gamma più ampia di notizie attuali. Poiché questo articolo è stato tradotto con traduzione automatica, è possibile che contenga errori di vocabolario, sintassi o grammatica. L'articolo originale in Inglese può essere trovato qui.